[AWS-SAP] 스터디 문제 31~40

![[AWS-SAP] 스터디 문제 31~40](/assets/img/study_AWS/2022-08-25-%5BAWS-SAP%5D_%EC%8A%A4%ED%84%B0%EB%94%94_%EB%AC%B8%EC%A0%9C_31~40/logo.png)

SAP 스터디에서 31~40번 문제를 풀어보자.

1차 x/10

- Prob. 31 ⭕❌

- Prob. 32 ⭕❌

- Prob. 33 ⭕❌

- Prob. 34 ⭕❌

- Prob. 35 ⭕❌

- Prob. 36 ⭕❌

- Prob. 37 ⭕❌

- Prob. 38 ⭕❌

- Prob. 39 ⭕❌

- Prob. 40 ⭕❌

Prob. 31 ⭕❌

회사는 환경 데이터를 처리합니다. 이 회사는 도시의 다양한 지역에서 지속적인 데이터 스트림을 제공하기 위해 센서를 설치했습니다. 데이터는 JSON 형식으로 제공됩니다. 이 회사는 AWS 솔루션을 사용하여 스토리지에 고정 스키마가 필요하지 않은 데이터베이스로 데이터를 전송하려고 합니다. 데이터는 실시간으로 전송되어야 합니다.

다음 중 이러한 요구 사항을 충족하는 솔루션은 무엇입니까?

(A). Amazon Kinesis Data Firehose를 사용하여 데이터를 Amazon Redshift로 전송합니다.

(B). Amazon Kinesis Data Streams를 사용하여 데이터를 Amazon DynamoDB로 전송합니다.

(C). Amazon Managed Streaming for Apache Kafka (Amazon MSK)를 사용하여 데이터를 Amazon Aurora로 전송합니다.

(D). Amazon Kinesis Data Firehose를 사용하여 데이터를 Amazon Keyspaces(for Apache Cassandra)로 전송합니다. Which solution will meet these requirements? (A). Use Amazon Kinesis Data Firehose to send the data to Amazon Redshift. (B). Use Amazon Kinesis Data Streams to send the data to Amazon DynamoDB (C). Use Amazon Managed Streaming for Apache Kafka (Amazon MSK) to send the data to Amazon Aurora. (D). Use Amazon Kinesis Data Firehose to send the data to Amazon Keyspaces (for Apache Cassandra) 해설 : 없음 1차 시도 : B 맞음 원문 보기

A company processes environmental data. The company has set up sensors to provide a continuous stream of data from different areas in a city. The data is available in JSON format. The company wants to use an AWS solution to send the data to a database that does not require fixed schemas for storage. The data must be sent in real time.정답 및 해설 보기

Answer : B

Prob. 32 ⭕❌

A사는 여러 AWS 계정을 사용하고 있습니다. 이 회사에는 공유 서비스 계정과 여러 개의 다른 계정(또는 다른 프로젝트)이 있습니다. 팀에는 프로젝트 계정에 VPC가 있습니다. 팀은 공유 서비스 계정에 있는 AWS Direct Connect 게이트웨이를 통해 이 VPC를 회사 네트워크에 연결하려고 합니다. 이 팀은 VPC 네트워킹 스택을 배포하는 동안 이미 테스트된 AWS Lambda 기능을 사용하여 Direct Connect 게이트웨이와 가상 사설 게이트웨이 연결을 자동으로 수행하려고 합니다. 람다 함수 코드는 AWS STS(Security Token Service)를 사용하여 역할을 수행할 수 있습니다. 이 팀은 AWS Cloud Formation을 사용하여 인프라를 구축하고 있습니다.

다음 중 이러한 요구 사항을 충족할 수 있는 단계는 무엇입니까? (3개 선택)

(A). Lambda 함수를 프로젝트 계정에 배포합니다. directconnect:* 권한을 사용하여 람다 기능의 IAM 역할을 업데이트합니다.

(B). Lambda 함수에 directconnect:* 권한을 부여하는 교차 계정 IAM 역할을 공유 서비스 계정에 만듭니다. sts를 추가합니다.공유 서비스 계정의 람다 기능과 관련된 IAM 역할에 대한 역할 권한을 가정합니다.

(C). 프로젝트 계정에서 람다 함수를 참조하는 사용자 지정 리소스를 Cloud Formation 네트워킹 스택에 추가합니다.

(D). 공유 서비스 계정에 연결을 수행하는 Lambda 함수를 배포합니다. directconnect:* 권한으로 람다 기능의 IAM 역할을 업데이트합니다.

(E). Create a cross-account IAM role in the shared services account that grants the sts: Assume Role permission to the Lambda function with the directconnect:* permission acting as a resource. Add the sts Assume Role permission with this cross-account IAM role as a resource to the IAM role that belongs to the Lambda function in the project account.

(F). 공유 서비스 계정의 람다 함수를 참조하는 사용자 지정 리소스를 Cloud Formation 네트워킹 스택에 추가합니다. Which combination of steps will meet these requirements? (Select THREE.) (A). Deploy the Lambda function to the project account. Update the Lambda function’s IAM role with the directconnect:* permission (B). Create a cross-account IAM role in the shared services account that grants the Lambda function the directconnect:” permission. Add the sts:AssumeRole permission to the IAM role that is associated with the Lambda function in the shared services account. (C). Add a custom resource to the Cloud Formation networking stack that references the Lambda function in the project account. (D). Deploy the Lambda function that is performing the association to the shared services account. Update the Lambda function’s IAM role with the directconnect:’ permission. (E). Create a cross-account IAM role in the shared services account that grants the sts: Assume Role permission to the Lambda function with the directconnect:” permission acting as a resource. Add the sts AssumeRole permission with this cross-account IAM role as a resource to the IAM role that belongs to the Lambda function in the project account. (F). Add a custom resource to the Cloud Formation networking stack that references the Lambda function in the shared services account. 해설 : 1차 시도 : 원문 보기

A company is using multiple AWS accounts. The company has a shared services account and several other accounts (or different projects. A team has a VPC in a project account. The team wants to connect this VPC to a corporate network through an AWS Direct Connect gateway that exists in the shared services account. The team wants to automatically perform a virtual private gateway association with the Direct Connect gateway by using an already-tested AWS Lambda function while deploying its VPC networking stack. The Lambda function code can assume a role by using AWS Security Token Service (AWS STS). The team is using AWS Cloud Formation to deploy its infrastructure.정답 및 해설 보기

Answer : B, C, E

Prob. 33 ⭕❌

A사는 중앙 위치에서 여러 부서에 대한 여러 AWS 계정을 생성하고 관리해야 합니다. 보안 팀은 자체 AWs 계정에서 모든 계정에 대한 읽기 전용 액세스 권한을 요구합니다. 그 회사는 AWS Organizations를 사용하고 있으며 보안팀에 계정을 만들었습니다.

솔루션 설계자는 이러한 요구사항을 어떻게 충족해야 합니까?

(A). 조직 계정 액세스 역할 IAM 역할을 사용하여 각 구성원 계정에 읽기 전용 액세스 권한을 가진 새 IAM 정책을 만듭니다. 각 회원 계정의 IAM 정책과 보안 계정 간에 신뢰 관계를 설정합니다. IAM 정책을 사용하여 액세스 권한을 얻도록 보안 팀에 요청하십시오.

(B). 조직 계정 액세스 역할 IAM 역할을 사용하여 각 구성원 계정에 읽기 전용 액세스 권한을 가진 새 IAM 역할을 만듭니다. 각 회원 계정의 IAM 역할과 보안 계정 간에 신뢰 관계를 설정합니다. IAM 역할을 사용하여 액세스 권한을 얻도록 보안 팀에 요청하십시오.

(C). 보안 팀에 AWS STS(Security Token Service)를 사용하여 보안 계정에서 마스터 계정의 조직 계정 액세스 역할 IAM 역할에 대한 역할 가정 API를 호출하도록 요청합니다. 생성된 임시 자격 증명을 사용하여 액세스 권한을 얻습니다.

(D). 보안팀에 AWS STS(Security Token Service)를 사용하여 보안 계정에서 회원 계정에 있는 조직 계정 액세스 역할 IAM 역할에 대한 역할 가정 API를 호출하도록 요청합니다. 생성된 임시 자격 증명을 사용하여 액세스 권한을 얻습니다. How should a solutions architect meet these requirements? (A). Use the OrganizationAccountAccessRole IAM role to create a new IAM policy wilh read-only access in each member account. Establish a trust relationship between the IAM policy in each member account and the security account. Ask the security team lo use the IAM policy to gain access. (B). Use the OrganizationAccountAccessRole IAM role to create a new IAM role with read-only access in each member account. Establish a trust relationship between the IAM role in each member account and the security account. Ask the security team lo use the IAM role to gain access. (C). Ask the security team to use AWS Security Token Service (AWS STS) to call the AssumeRole API for the OrganizationAccountAccessRole IAM role in the master account from the security account. Use the generated temporary credentials to gain access. (D). Ask the security team to use AWS Security Token Service (AWS STS) to call the AssumeRole API for the OrganizationAccountAccessRole IAM role in the member account from the security account. Use the generated temporary credentials to gain access. 해설 : 1차 시도 : 원문 보기

A company needs to create and manage multiple AWS accounts for a number of departments from a central location. The security team requires read-only access to all accounts from its own AWs account. The company is using AWS Organizations and created an account tor the security team.정답 및 해설 보기

Answer : D

Prob. 34 ⭕❌

한 비디오 스트리밍 회사가 최근 비디오 공유를 위한 모바일 앱을 출시했습니다. 앱은 us-east-1 영역의 Amazon S3 버킷에 다양한 파일을 업로드합니다. 파일 크기는 1GB에서 10GB까지입니다. 호주에서 앱에 접속하는 사용자들은 오랜 시간이 걸리는 업로드를 경험했습니다. 이러한 사용자의 파일이 완전히 업로드되지 않는 경우가 있습니다. 솔루션 설계자는 이러한 업로드를 위해 앱의 성능을 향상시켜야 합니다.

다음 중 이러한 요구 사항을 충족하는 솔루션은 무엇입니까? (2개를 선택합니다.)

(A). S3 버킷에서 S3 전송 가속 사용 업로드에 전송 가속 끝점을 사용하도록 앱을 구성합니다.

(B). 각 Region에서 S3 버킷을 구성하여 업로드를 수신합니다. S3 지역 간 복제를 사용하여 파일을 배포 S3 버킷에 복사합니다.

(C). 가장 가까운 S3 버킷 영역으로 업로드를 라우팅하기 위해 지연 시간 기반 라우팅을 사용하는 Amazon Route 53을 설정합니다.

(D). 동영상 파일을 청크로 나누도록 앱 구성 Amazon S3로 파일을 전송하려면 다중 부분 업로드를 사용하십시오.

(E). 업로드하기 전에 파일에 임의 접두사를 추가하도록 앱을 수정하십시오. Which solutions will meet these requirements? (Select TWO.) (A). Enable S3 Transfer Acceleration on the S3 bucket Configure the app to use the Transfer Acceleration endpoint for uploads (B). Configure an S3 bucket in each Region to receive the uploads. Use S3 Cross-Region Replication to copy the files to the distribution S3 bucket. (C). Set up Amazon Route 53 with latency-based routing to route the uploads to the nearest S3 bucket Region. (D). Configure the app to break the video files into chunks Use a multipart upload to transfer files to Amazon S3. (E). Modify the app to add random prefixes to the files before uploading 해설 : 1차 시도 : 원문 보기

A video streaming company recently launched a mobile app for video sharing. The app uploads various files to an Amazon S3 bucket in the us-east-1 Region. The files range in size from 1 GB to 10 GB. Users who access the app from Australia have experienced uploads that take long periods of time. Sometimes the files fail to completely upload for these users. A solutions architect must improve the app’s performance for these uploads.정답 및 해설 보기

Answer : A, C

Prob. 35 ⭕❌

A사는 프런트 엔드 및 전자 상거래 계층이 있는 전자 상거래 플랫폼을 운영하고 있습니다. 두 계층은 모두 LAMP 스택에서 실행되며, 로드 밸런싱 어플라이언스에서 실행되는 프런트 엔드 인스턴스는 AWS Current*/에서 가상 오퍼링을 제공합니다. 운영 팀은 SSH를 사용하여 인스턴스에 로그인하여 패치를 유지하고 다른 문제를 해결합니다. 이 플랫폼은 최근 다음과 같은 여러 공격의 표적이 되었습니다.

- A DDoS attack.

- An SQL injection attack.

- 웹 서버의 SSH 계정에 대한 몇 가지 성공적인 사전 공격이 있습니다. 그 회사는 AWS로 마이그레이션하여 전자 상거래 플랫폼의 보안을 개선하고자 합니다. 회사의 솔루션 설계자는 다음과 같은 접근 방식을 사용하기로 결정했습니다.

- 기존 응용 프로그램을 코드 검토하고 SQL 주입 문제를 해결합니다.

- 웹 애플리케이션을 AWS로 마이그레이션하고 최신 AWS Linux AMI를 활용하여 초기 보안 패치를 해결합니다.

- AWS Systems Manager를 설치하여 패치 적용을 관리하고 시스템 관리자가 필요에 따라 모든 인스턴스에 대해 명령을 실행할 수 있도록 합니다.

고가용성을 제공하고 위험을 최소화하면서 확인된 모든 공격 유형을 해결할 수 있는 추가 단계는 무엇입니까?

(A). 특정 IP에 대한 액세스를 제한하는 Security Group을 사용하여 Amazon EC2 인스턴스에 대한 SSH 액세스를 사용하도록 설정합니다. 사내 MySQL을 Amazon RDS Multi-AZ로 마이그레이션 AWS Marketplace에서 타사 로드 밸런서를 설치하고 기존 규칙을 로드 밸런서의 AWS 인스턴스로 마이그레이션합니다. DDoS 보호를 위한 AWS Shield Standard를 사용합니다.

(B). Amazon EC2 인스턴스에 대한 SSH 액세스를 사용하지 않도록 설정합니다. 사내 MySQL을 Amazon RDS Multi-AZ로 마이그레이션 Elastic Load Balancer를 활용하여 로드를 분산하고 AWS Shield Advanced를 보호하도록 설정합니다. 웹 사이트 앞에 Amazon CloudFront 배포를 추가합니다. 배포에서 AWS WAF를 사용하도록 설정하여 규칙을 관리합니다.

(C). 특정 IP 주소에 대한 액세스를 제한하여 보안 보호 호스트를 통해 Amazon EC2 인스턴스에 대한 SSH 액세스를 사용하도록 설정합니다. 사내 MySQL을 자체 관리 EC2 인스턴스로 마이그레이션합니다. AWS Elastic Load Balancer를 활용하여 로드를 분산하고 AWS Shield Standard for DDoS 보호를 사용하도록 설정합니다. 웹 사이트 앞에 Amazon CloudFront 배포판을 추가합니다.

(D). EC2 인스턴스에 대한 SSH 액세스를 사용하지 않도록 설정합니다. 사내 MySQL을 Amazon RDS Single-AZ로 마이그레이션합니다. AWS Elastic Load Balancer를 활용하여 웹 사이트 앞에 Amazon CloudFront 배포를 추가합니다. 배포에서 AWS WAF를 사용하도록 설정하여 규칙을 관리합니다. What additional steps will address all of the identified attack types while providing high availability and minimizing risk? (A). Enable SSH access to the Amazon EC2 instances using a security group that limits access to specific IPs. Migrate on-premises MySQL to Amazon RDS Multi-AZ Install the third-party load balancer from the AWS Marketplace and migrate the existing rules to the load balancer’s AWS instances. Enable AWS Shield Standard for DDoS protection (B). Disable SSH access to the Amazon EC2 instances. Migrate on-premises MySQL to Amazon RDS Multi-AZ Leverage an Elastic Load Balancer to spread the load and enable AWS Shield Advanced for protection. Add an Amazon CloudFront distribution in front of the website Enable AWS WAF on the distribution to manage the rules. (C). Enable SSH access to the Amazon EC2 instances through a bastion host secured by limiting access to specific IP addresses. Migrate on-premises MySQL to a self-managed EC2 instance. Leverage an AWS Elastic Load Balancer to spread the load, and enable AWS Shield Standard for DDoS protection. Add an Amazon CloudFront distribution in front of the website. (D). Disable SSH access to the EC2 instances. Migrate on-premises MySQL to Amazon RDS Single-AZ. Leverage an AWS Elastic Load Balancer to spread the load Add an Amazon CloudFront distribution in front of the website. Enable AWS WAF on the distribution to manage the rules. 해설 : 1차 시도 : 원문 보기

A company runs an e-commerce platform with front-end and e-commerce tiers. Both tiers run on LAMP stacks with the front-end instances running behind a load balancing appliance that has a virtual offering on AWS Current*/, the operations team uses SSH to log in to the instances to maintain patches and address other concerns. The platform has recently been the target of multiple attacks, including정답 및 해설 보기

Answer : B

Prob. 36 ⭕❌

유럽과 아시아에 사무소를 두고 가전제품을 개발하는 한 회사는 유럽의 구내에 60TB의 소프트웨어 이미지를 저장하고 있습니다. 이 회사는 이미지를 ap-northest-1 영역에 있는 Amazon S3 버킷으로 전송하려고 합니다. 새 소프트웨어 이미지는 매일 생성되므로 전송 중에 암호화해야 합니다. 회사는 기존의 모든 소프트웨어 이미지와 새로운 소프트웨어 이미지를 자동으로 아마존 S3로 전송하기 위해 맞춤형 개발이 필요하지 않은 솔루션이 필요합니다.

양도 과정의 다음 단계는 무엇입니까?

(A). AWS DataSync 에이전트를 배포하고 이미지를 S3 버킷으로 전송하는 작업을 구성합니다.

(B)S3 전송 가속을 사용하여 이미지를 전송하도록 Amazon Kinesis Data Firehose를 구성합니다.

(C)AWS Snowball 장치를 사용하여 S3 버킷을 대상으로 이미지를 전송합니다.

(D). 다중 부분 업로드가 포함된 S3 API를 사용하여 사이트 간 VPN 연결을 통해 이미지를 전송합니다. What is the next step in the transfer process? (A). Deploy an AWS DataSync agent and configure a task to transfer the images to the S3 bucket. (B). Configure Amazon Kinesis Data Firehose to transfer the images using S3 Transfer Acceleration. (C). Use an AWS Snowball device to transfer the images with the S3 bucket as the target. (D). Transfer the images over a Site-to-Site VPN connection using the S3 API with multipart upload. 해설 : 1차 시도 : 원문 보기

A company that develops consumer electronics with offices in Europe and Asia has 60 TB of software images stored on premises in Europe. The company wants to transfer the images to an Amazon S3 bucket in the ap-northeast-1 Region. New software images are created daily and must be encrypted in transit. The company needs a solution that does not require custom development to automatically transfer all existing and new software images to Amazon S3.정답 및 해설 보기

Answer : A

Prob. 37 ⭕❌

A사는 최근 AWS 클라우드에서 새로운 애플리케이션 워크로드를 호스팅하기 시작했습니다. 회사에서 Amazon EC2 인스턴스를 사용하고 있습니다. Amazon EFS(Elastic File System) 파일 시스템 및 Amazon RDS DB 인스턴스입니다. 규제 및 비즈니스 요구사항을 충족하기 위해 회사는 데이터 백업에 대해 다음과 같은 사항을 변경해야 합니다.

- 백업은 일별, 주별 및 월별 사용자 지정 요구 사항에 따라 유지되어야 합니다.

- 백업은 캡처 후 즉시 하나 이상의 다른 AWS 영역으로 복제해야 합니다.

- 백업 솔루션은 AWS 환경에서 단일 원본 백업 상태를 제공해야 합니다.

- 백업 솔루션은 리소스 백업에 실패하면 즉시 알림을 전송해야 합니다.

최소 작동량으로 이러한 요구 사항을 충족할 수 있는 단계의 조합은 무엇입니까? 머리 위요? (3개 선택)

(A). 각 보존 요구 사항에 대한 백업 규칙을 사용하여 AWS 백업 계획을 생성합니다.

(B). AWS 백업 계획을 구성하여 백업을 다른 영역으로 복사합니다.

(C). AWS Lambda 함수를 생성하여 백업을 다른 영역으로 복제하고 실패 시 알림을 보냅니다.

(D). 백업 계획에 Amazon Simple Notification Service(Amazon SNS) 항목을 추가하여 BACKUP_JOB_COMPLETEO를 제외한 모든 상태의 완료된 작업에 대한 알림을 보냅니다.

(E). 각 보존 요구 사항에 대해 Amazon DLM(Amazon Data Lifecycle Manager) 스냅샷 수명 주기 정책을 생성합니다.

(F). 각 데이터베이스에 RDS 스냅샷을 설정합니다. Which combination of steps will meet these requirements with the LEAST amount of operational overhead? (Select THREE.) (A). Create an AWS Backup plan with a backup rule for each of the retention requirements. (B). Configure an AWS Backup plan to copy backups to another Region. (C). Create an AWS Lambda function to replicate backups to another Region and send notification if a failure occurs. (D). Add an Amazon Simple Notification Service (Amazon SNS) topic to the backup plan to send a notification for finished jobs that have any status except BACKUP_JOB_COMPLETEO. (E). Create an Amazon Data Lifecycle Manager (Amazon DLM) snapshot lifecycle policy for each of the retention requirements. (F). Set up RDS snapshots on each database. 해설 : 1차 시도 : 원문 보기

A company recently started hosting new application workloads in the AWS Cloud. The company is using Amazon EC2 instances. Amazon Elastic File System (Amazon EFS) file systems, and Amazon RDS DB instances. To meet regulatory and business requirements, the company must make the following changes for data backups:정답 및 해설 보기

Answer : B, D, E

Prob. 38 ⭕❌

소매업체는 일련의 데이터 파일을 다른 회사에 제공해야 합니다. 사업 파트너인 회사입니다. 이러한 파일은 계정 A의 Amazon S3 버킷에 저장됩니다. 그것은 소매 회사의 것입니다. 비즈니스 파트너 회사에서 IAM 사용자 User_DataProcessor 중 하나가 자체 AWS 계정(계정 B)에서 파일에 액세스하기를 원합니다.

User_DataProcessor가 S3 버킷에 성공적으로 액세스하기 위해 회사에서 수행해야 하는 단계는 무엇입니까? (2개 선택)

(A). 계정 A에서 S3 버킷에 대한 CORS(Cross-Origin Resource Sharing) 기능을 켜십시오.

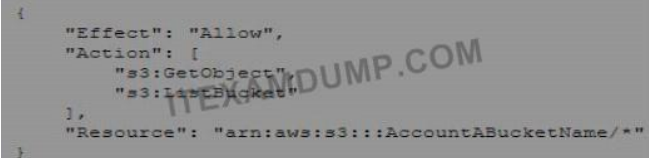

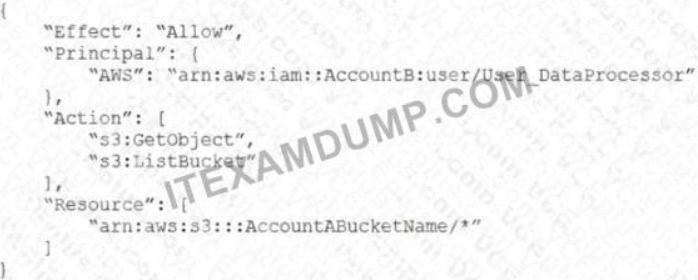

(B). 계정 A에서 S3 버킷 정책을 다음과 같이 설정합니다.

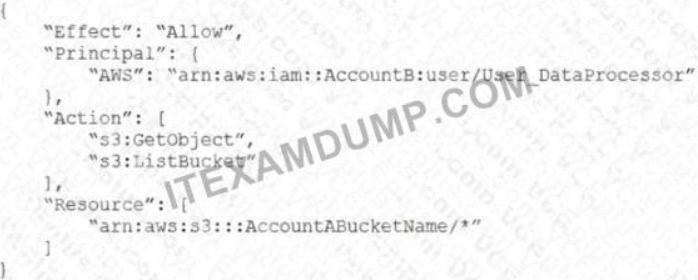

(C). 계정 A에서 S3 버킷 정책을 다음과 같이 설정합니다.

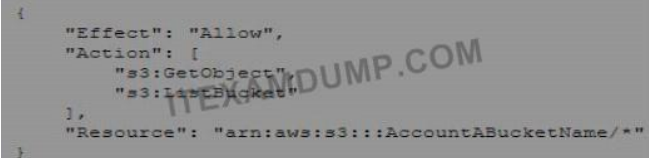

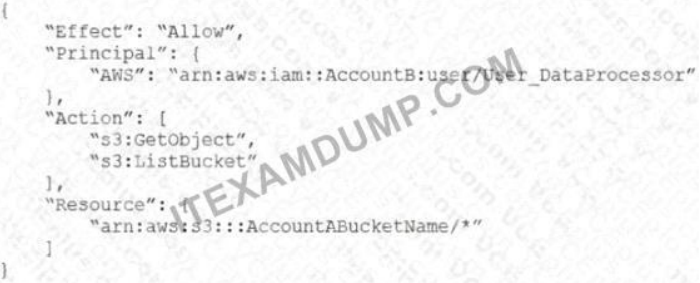

(D). 계정 B에서 User_DataProcessor의 권한을 다음과 같이 설정합니다.

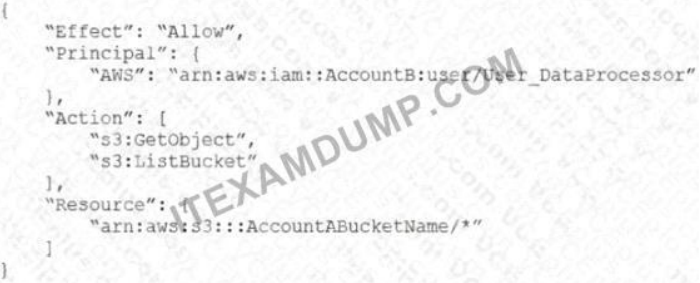

(E). 계정 B에서 User_DataProcessor의 권한을 다음과 같이 설정합니다.

Which combination of steps must the companies take so that User_DataProcessor can access the S3 bucket successfully? (Select TWO.) (A). Turn on the cross-origin resource sharing (CORS) feature for the S3 bucket in Account A. (B). In Account A. set the S3 bucket policy to the following. (C). In Account A, set the S3 bucket policy to the following: (D). InAccount B, set the permissions of User_DataProcessor to the following: (E). InAccount B, set the permissions of User_DataProcessor to the following: 해설 : 1차 시도 :

원문 보기

A retail company needs to provide a series of data files to another company. which is its business partner. These files are saved in an Amazon S3 bucket under Account A. Which belongs to the retail company. The business partner company wants one of its IAM users User_DataProcessor to access the files from its own AWS account (Account B)

정답 및 해설 보기

Answer : A, D

Prob. 39 ⭕❌

A사는 AWS WAF 솔루션을 배포하여 여러 AWS 계정에서 AWS WAF 규칙을 관리하려고 합니다. 계정은 AWS 조직의 여러 OU에서 관리됩니다. 관리자는 필요에 따라 관리되는 AWS WAF 규칙 집합에서 계정 또는 OU를 추가하거나 제거할 수 있어야 합니다. 또한 관리자는 모든 계정의 비준수 AWS WAF 규칙을 자동으로 업데이트하고 수정할 수 있어야 합니다.

운영 오버헤드를 최소화하면서 이러한 요구 사항을 충족하는 솔루션은 무엇입니까?

(A). AWS Firewall Manager를 사용하여 조직의 여러 계정에서 AWS WAF 규칙을 관리합니다. AWS Systems Manager Parameter Store 매개 변수를 사용하여 계정 번호와 OU를 저장하여 관리할 수 있습니다. 필요에 따라 매개 변수 업데이트를 사용하여 계정 또는 OU를 추가하거나 제거할 수 있습니다. Amazon EventBridge(Amazon CloudWatch Events) 규칙을 사용하여 매개 변수의 변경 사항을 식별하고 AWS Lambda 함수를 호출하여 방화벽 관리자 관리 계정의 보안 정책을 업데이트합니다.

(B). 선택한 OU의 모든 리소스가 AWS WAF 규칙을 연결하도록 요구하는 조직 전체의 AWS Conng 규칙을 배포합니다. AWS Lambda를 사용하여 비준수 리소스를 수정하여 자동화된 업데이트 적용 작업을 배포합니다. AWS CloudFormation 스택 집합을 사용하여 AWS 구성 규칙이 적용되는 동일한 OU를 대상으로 하여 AWS WAF 규칙을 배포합니다.

(C). 조직의 관리 계정에 AWS WAF 규칙을 만듭니다. AWS Lambda 환경 변수를 사용하여 계정 번호를 저장하고 OU를 사용하여 필요에 따라 업데이트 환경 변수를 관리하거나 OU 멤버 계정에 교차 계정 IAM 역할을 만듭니다. 람다 함수의 AWS STS(Security Token Service)를 사용하여 멤버 계정에서 AWS WAF 규칙을 만들고 업데이트하여 역할을 가정합니다.

(D). AWS Control Tower를 사용하여 조직의 여러 계정에서 AWS WAF 규칙을 관리합니다. 계정 또는 OU를 추가하거나 제거하는 데 필요한 경우 AWS KMS(AWS Key Management Service)를 사용하여 계정 번호 및 OU를 저장하여 AWS KMS 업데이트를 관리합니다. 구성원 계정에 IAM 사용자 생성 관리 계정의 AWS Control Tower에서 액세스 키 및 개인 액세스 키를 사용하여 구성원 계정에 AWS WAF 규칙을 만들고 업데이트할 수 있습니다. Which solution meets these requirements with the LEAST amount of operational overhead? (A). Use AWS Firewall Manager to manage AWS WAF rules across accounts in the organization. Use an AWS Systems Manager Parameter Store parameter to store account numbers and OUs to manage Update the parameter as needed to add or remove accounts or OUs. Use an Amazon EventBridge (Amazon CloudWatch Events) rule to identify any changes to the parameter and to invoke an AWS Lambda function to update the security policy in the Firewall Manager administrative account. (B). Deploy an organization-wide AWS Conng rule that requires all resources in the selected OUs to associate the AWS WAF rules. Deploy automated remediation actions by using AWS Lambda to fix noncompliant resources. Deploy AWS WAF rules by using an AWS CloudFormation stack set to target the same OUs where the AWS Config rule is applied. (C). Create AWS WAF rules in the management account of the organization. Use AWS Lambda environment variables to store account numbers and OUs to manage Update environment variables as needed to add or remove accounts or OUs Create cross-account IAM roles in member accounts. Assume the roles by using AWS Security Token Service (AWS STS) in the Lambda function to create and update AWS WAF rules in the member accounts. (D). Use AWS Control Tower to manage AWS WAF rules across accounts in the organization. Use AWS Key Management Service (AWS KMS) to store account numbers and OUs to manage Update AWS KMS as needed to add or remove accounts or OUs. Create IAM users in member accounts Allow AWS Control Tower in the management account to use the access key and secret access key to create and update AWS WAF rules in the member accounts. 해설 : 1차 시도 : 원문 보기

A company wants to deploy an AWS WAF solution to manage AWS WAF rules across multiple AWS accounts. The accounts are managed under different OUs in AWS Organizations. Administrators must be able to add or remove accounts or OUs from managed AWS WAF rule sets as needed. Administrators also must have the ability to automatically update and remediate noncompliant AWS WAF rules in all accounts.정답 및 해설 보기

Answer : B

Prob. 40 ⭕❌

한 데이터 분석 회사에는 여러 예약된 노드로 구성된 Amazon Redshift 클러스터가 있습니다. 직원 팀이 심층 감사 분석 보고서를 작성하고 있기 때문에 더스터에서 예상치 못한 사용량이 급증하고 있습니다. 보고서를 생성하는 쿼리는 복잡한 읽기 쿼리로 CPU를 많이 사용합니다. 비즈니스 요구 사항에 따라 클러스터는 항상 읽기 및 쓰기 쿼리를 처리할 수 있어야 합니다. 솔루션 설계자는 급증하는 사용량을 수용할 수 있는 솔루션을 고안해야 합니다.

다음 중 가장 비용 효율적으로 이러한 요구사항을 충족하는 솔루션은 무엇입니까?

(A). Amazon EMR Duster를 프로비저닝합니다. 복잡한 데이터 처리 작업을 오프로드합니다.

(B).AWS Lambda 함수를 배포하여 Amazon CloudWatch에서 더스터의 CPU 메트릭이 80%에 도달하면 고전적인 크기 조정 작업을 사용하여 Amazon Redshift 클러스터에 용량을 추가합니다.

(C)AWS Lambda 기능을 배포하여 Amazon CloudWatch에서 더스터의 CPU 메트릭이 80%에 도달할 때 탄력적인 크기 조정 작업을 사용하여 Amazon Redshift 더스터에 용량을 추가합니다.

(D). Amazon Redshift 더스터에 대한 동시성 스케일링 기능을 설정합니다. Which solution meets these requirements MOST cost-effectively? (A). Provision an Amazon EMR duster Offload the complex data processing tasks. (B). Deploy an AWS Lambda function to add capacity to the Amazon Redshift cluster by using a classic resize operation when the duster’s CPU metrics in Amazon CloudWatch reach 80%. (C). Deploy an AWS Lambda function to add capacity to the Amazon Redshift duster by using an elastic resize operation when the duster’s CPU metrics in Amazon CloudWatch leach 80%. (D). Turn on the Concurrency Scaling feature for the Amazon Redshift duster 해설 : 1차 시도 : 원문 보기

A data analytics company has an Amazon Redshift cluster that consists of several reserved nodes. The duster is experiencing unexpected bursts of usage because a team of employees is compiling a deep audit analysis report The queries to generate the report are complex read queries and are CPU intensive. Business requirements dictate that the cluster must be able to service read and write queries at all times. A solutions architect must devise a solution that accommodates the bursts of usage.정답 및 해설 보기

Answer : D

- Ref